Der Umstieg auf Echtzeit-Datenverarbeitung ist kein Upgrade, sondern ein Paradigmenwechsel: weg von der Analyse alter Daten, hin zur Steuerung von Geschäftsprozessen in der Gegenwart.

- Die Architektur wandelt sich von Batch-Verarbeitung (Data-at-Rest) zu Event-Streaming (Data-in-Motion).

- Dies ermöglicht proaktive Anwendungen wie Predictive Maintenance und sofortige Betrugserkennung, anstatt nur reaktiv zu berichten.

Empfehlung: Analysieren Sie, wo in Ihrem Unternehmen Latenz Kosten verursacht, und starten Sie dort mit einem Pilotprojekt.

Für jeden E-Commerce-Manager, Logistikleiter oder Finanzanalysten ist es eine frustrierende Realität: Die Daten, auf deren Basis heute Entscheidungen getroffen werden müssen, sind oft bereits veraltet. Der Report vom Vortag bildet die rasante Marktdynamik nicht mehr ab, die Lagerbestände sind bereits überholt und die verdächtige Transaktion wurde erst Stunden später entdeckt. In einer Welt, die in Millisekunden operiert, werden Entscheidungen auf Basis von Daten von gestern zu einem teuren Glücksspiel.

Die übliche Antwort auf dieses Problem lautet oft, bestehende Datenbanken zu beschleunigen oder Reporting-Zyklen zu verkürzen. Man spricht von Big Data und schnelleren Abfragen. Doch dies sind oft nur inkrementelle Verbesserungen eines veralteten Systems. Sie kratzen an der Oberfläche, ohne das Kernproblem zu lösen: die fundamentale Latenz, die in der traditionellen Batch-Verarbeitung von Daten – dem sogenannten „Data-at-Rest“-Ansatz – fest verankert ist.

Aber was wäre, wenn die Lösung nicht darin bestünde, alte Daten schneller abzufragen, sondern darin, Daten gar nicht erst alt werden zu lassen? Hier liegt der Kern der Echtzeit-Datenverarbeitung. Es geht um einen fundamentalen architektonischen Wechsel hin zu „Data-in-Motion“. Anstatt Daten zu sammeln, zu speichern und dann zu analysieren, werden Daten als kontinuierlicher Strom von Ereignissen (Events) behandelt, der live verarbeitet und für sofortige Aktionen genutzt wird. Es ist der Wandel von der reaktiven Analyse zur proaktiven Steuerung.

Dieser Artikel führt Sie durch diesen Paradigmenwechsel. Wir beleuchten nicht nur, was Echtzeit-Datenverarbeitung technisch bedeutet, sondern vor allem, welchen strategischen Hebel sie für Ihr Unternehmen darstellt. Wir untersuchen konkrete Anwendungsfälle, die technologischen Grundlagen und die organisatorischen Schritte, die notwendig sind, um Ihr Unternehmen fit für das Echtzeit-Zeitalter zu machen und sich einen nachhaltigen Wettbewerbsvorteil zu sichern.

Um die strategischen und operativen Dimensionen der Echtzeit-Datenverarbeitung vollständig zu erfassen, haben wir diesen Artikel in übersichtliche Abschnitte gegliedert. Die folgende Übersicht dient Ihnen als Wegweiser durch die Kernthemen dieses Leitfadens.

Inhaltsverzeichnis: Vom Datenstrom zur strategischen Entscheidung

- Was ist Echtzeit-Datenverarbeitung und warum ist sie ein Game-Changer?

- Anwendungsfälle für Echtzeit-Daten: Von der Betrugserkennung bis zur personalisierten Werbung

- Datensicherheit vs. Datenschutz (DSGVO): Was ist der Unterschied und was müssen Sie beachten?

- Ein Blick in den Maschinenraum: Die Technologien, die Echtzeit-Datenverarbeitung möglich machen

- Schnelle Daten, schnelle Entscheidungen: Wie Sie Ihre Organisation fit für das Echtzeit-Zeitalter machen

- Digital, aber sicher: Die grundlegenden Cybersicherheits-Massnahmen für jedes KMU

- Die Technik hinter der Magie: Wie CRM-Systeme und Co. die persönliche Kundenansprache ermöglichen

- Vom Datenfriedhof zum strategischen Schatz: Wie Sie Datenanalyse zur Entscheidungsfindung nutzen

Was ist Echtzeit-Datenverarbeitung und warum ist sie ein Game-Changer?

Echtzeit-Datenverarbeitung ist mehr als nur „schnelle“ Datenanalyse. Sie beschreibt die Fähigkeit eines Systems, Datenströme kontinuierlich zu erfassen, zu verarbeiten und darauf zu reagieren – und das innerhalb von Millisekunden bis Sekunden. Im Gegensatz zur traditionellen Batch-Verarbeitung, bei der Daten gesammelt und in periodischen Intervallen (z. B. nächtlich) verarbeitet werden, analysiert die Echtzeit-Verarbeitung Data-in-Motion. Das bedeutet, die Analyse findet statt, während die Daten noch durch die Systeme fliessen.

Der entscheidende Unterschied liegt im Paradigma: Batch-Systeme beantworten Fragen über die Vergangenheit („Was war der Gesamtumsatz gestern?“), während Echtzeit-Systeme auf Ereignisse in der Gegenwart reagieren („Ein Kunde mit verdächtigem Kaufverhalten legt gerade einen Artikel in den Warenkorb – blockieren?“). Dieser Wechsel von der reaktiven Berichterstattung zur proaktiven Steuerung ist der eigentliche Game-Changer. Viele Unternehmen, insbesondere im deutschen Mittelstand, nutzen im Rahmen ihrer Industrie-4.0-Vorhaben immer noch traditionelle Datenbanken, was zu langsamen Prozessen führt. Die Lösung ist der Wandel hin zur ereignisgesteuerten Verarbeitung durch Echtzeit-Streaming.

Die Relevanz dieses Ansatzes zeigt sich in der Marktakzeptanz führender Technologien. Während genaue Zahlen für Deutschland schwer zu erheben sind, zeigt der US-Markt eine klare Richtung: Laut eigenen Angaben von Apache Kafka, einer Schlüsseltechnologie für Event-Streaming, setzen dort über 80 % der umsatzstärksten Fortune-100-Unternehmen auf diese Plattform. Dies signalisiert einen unumkehrbaren Trend, der auch für den deutschen Markt massgeblich ist. Es geht nicht mehr darum, ob man Echtzeit-Fähigkeiten braucht, sondern wie man sie implementiert, um nicht den Anschluss zu verlieren.

Die Unterscheidung zwischen „Echtzeit“ und „Nahezu-Echtzeit“ (Near-Real-Time) ist hierbei von praktischer Bedeutung. Echte Echtzeit ist oft für hochkritische Systeme wie in der Luft- und Raumfahrt erforderlich, wo Latenzen im Mikrosekundenbereich entscheidend sind. Für die meisten Geschäftsanwendungen, von der Logistik bis zum E-Commerce, ist eine Verarbeitung im Millisekunden- bis Sekundenbereich („Nahezu-Echtzeit“) ausreichend und stellt bereits einen transformativen Sprung dar.

Anwendungsfälle für Echtzeit-Daten: Von der Betrugserkennung bis zur personalisierten Werbung

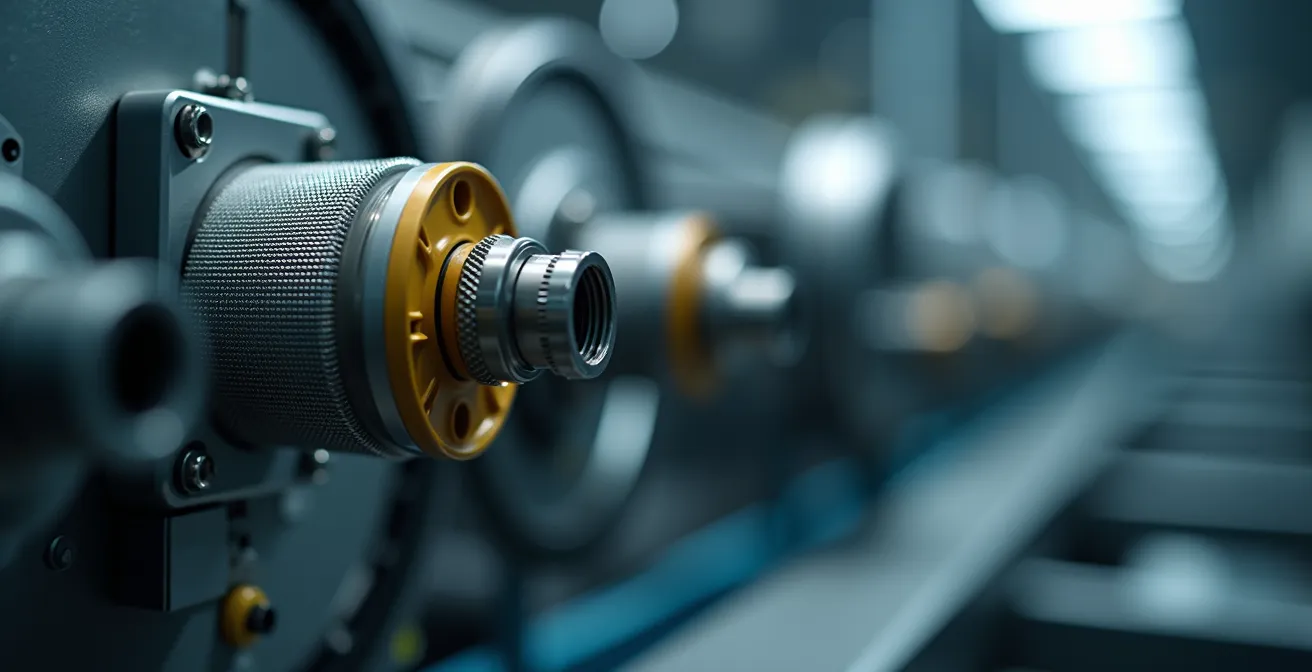

Die wahre Stärke der Echtzeit-Datenverarbeitung zeigt sich in ihren praktischen Anwendungen, die weit über schnellere Dashboards hinausgehen. Sie ermöglichen völlig neue, proaktive Geschäftsmodelle. Ein Paradebeispiel aus der deutschen Industrie ist die Predictive Maintenance im Maschinenbau. Anstatt auf den Ausfall einer Komponente zu warten oder Wartungsintervalle starr festzulegen, analysieren Sensoren kontinuierlich Daten wie Vibration, Temperatur und Druck. Algorithmen erkennen Anomalien in Echtzeit und melden einen drohenden Ausfall, bevor er eintritt.

Die Ergebnisse sind signifikant und direkt messbar. Studien belegen, dass durch diesen Ansatz eine Reduzierung der Stillstandszeiten um bis zu 25 % und eine Senkung der Wartungskosten um 20 % möglich sind. Für den produzierenden Mittelstand in Deutschland ist dies ein direkter Hebel zur Steigerung der Wettbewerbsfähigkeit.

Wie die Abbildung andeutet, sind IoT-Sensoren das Nervensystem solcher Anwendungen. Weitere klassische Anwendungsfälle umfassen:

- Betrugserkennung im Finanzsektor: Kreditkartentransaktionen werden in Millisekunden gegen Risikoprofile und Verhaltensmuster geprüft. Eine verdächtige Transaktion kann blockiert werden, bevor der Schaden entsteht.

- Dynamische Preisgestaltung im E-Commerce: Preise für Produkte oder Lieferoptionen können in Echtzeit an Nachfrage, Wettbewerbspreise und Lagerbestände angepasst werden.

- Personalisierte Kundenansprache: Ein Online-Shop kann das Klickverhalten eines Nutzers live analysieren und ihm im nächsten Moment passende Produktempfehlungen oder einen personalisierten Rabatt ausspielen.

- Supply-Chain-Optimierung: Logistikunternehmen können auf unvorhergesehene Ereignisse wie Staus oder Verspätungen sofort reagieren, Routen dynamisch anpassen und Kunden proaktiv informieren.

Ihr Aktionsplan: Predictive Maintenance im Pilotprojekt umsetzen

- Sensor-Audit: Nutzen Sie vorhandene Sensoren oder evaluieren Sie die kostengünstige Nachrüstung von Legacy-Equipment zur Datenerfassung.

- Datenübertragung einrichten: Definieren Sie geeignete und sichere Übertragungskanäle (z. B. MQTT, OPC UA) für die erfassten Sensordaten.

- Pilotprojekt starten: Beginnen Sie mit einer kleinen, überschaubaren Anwendung, z. B. der Überwachung einer einzelnen, kritischen Maschine.

- Vorhersagemodell entwickeln: Erstellen Sie ein initiales Modell auf Basis von Anomalien in den Sensordaten, um Abweichungen vom Normalbetrieb zu erkennen.

- Kontinuierlich verbessern: Implementieren Sie Machine-Learning-Algorithmen, um das Modell mit jedem neuen Datenpunkt zu verfeinern und die Vorhersagegenauigkeit zu steigern.

Datensicherheit vs. Datenschutz (DSGVO): Was ist der Unterschied und was müssen Sie beachten?

Wenn Daten in Millisekunden fliessen, potenzieren sich auch die Risiken. Die Implementierung von Echtzeit-Systemen erfordert eine klare Unterscheidung zweier oft verwechselter Disziplinen: Datensicherheit und Datenschutz. Beide sind entscheidend, verfolgen aber unterschiedliche Ziele. Datensicherheit (Information Security) hat das Ziel, die Daten und Systeme selbst zu schützen. Es geht um die technischen Massnahmen zur Abwehr von externen und internen Bedrohungen. Im Kontext von Echtzeit-Datenströmen bedeutet das primär den Schutz der Datenpipeline vor Hackerangriffen, DDoS-Attacken auf Streaming-Endpunkte oder die Absicherung von unzähligen IoT-Geräten.

Der Datenschutz (Data Privacy) hingegen fokussiert auf den Schutz der Rechte und Freiheiten der Personen, deren Daten verarbeitet werden. In Deutschland und der EU ist die Datenschutz-Grundverordnung (DSGVO) der massgebliche rechtliche Rahmen. Hier geht es nicht um die technische Integrität der Daten, sondern um deren rechtmässige Verarbeitung. Fragen wie „Darf ich das Klickverhalten dieses Nutzers in Echtzeit für personalisierte Werbung nutzen?“, „Habe ich eine gültige Einwilligung?“ oder „Wie setze ich das Recht auf Löschung in einem kontinuierlichen Datenstrom um?“ stehen im Mittelpunkt.

Die folgende Tabelle verdeutlicht die zentralen Unterschiede im Kontext von Echtzeit-Anwendungen:

| Aspekt | Datensicherheit | Datenschutz (DSGVO) |

|---|---|---|

| Fokus | Schutz der Echtzeit-Pipeline vor Hackerangriffen | Regelung personalisierter Angebote in Echtzeit |

| Ziel | Technische Integrität und Verfügbarkeit | Rechte der betroffenen Personen |

| Massnahmen | DDoS-Schutz, IoT-Absicherung | Pseudonymisierung, Löschkonzepte |

| Verantwortung | IT-Abteilung | Datenschutzbeauftragter |

Die Rechenschaftspflicht („Accountability“) ist ein Kernprinzip der DSGVO. Unternehmen müssen nachweisen können, dass sie die Vorschriften einhalten. Wie Experten betonen, ist eine systematische Überwachung hier unerlässlich. Prof. Dr. Rainer W. Gerling, ein anerkannter Experte auf diesem Gebiet, erklärt dazu in den DATAKONTEXT Seminaren:

Die DS-GVO fordert vom Verantwortlichen eine umfassende Rechenschaftspflicht (‚Accountability‘). Kennzahlen und KPIs können einen wesentlichen Beitrag dazu leisten, dass datenschutzrechtliche Pflichten adäquat erfüllt werden.

– Prof. Dr. Rainer W. Gerling, DATAKONTEXT Seminare

Für Unternehmen in Deutschland bedeutet das, dass die Einführung von Echtzeit-Systemen von Anfang an eine enge Zusammenarbeit zwischen IT-Sicherheit und dem Datenschutzbeauftragten erfordert. Technische Machbarkeit und rechtliche Zulässigkeit müssen Hand in Hand gehen.

Ein Blick in den Maschinenraum: Die Technologien, die Echtzeit-Datenverarbeitung möglich machen

Die Umsetzung von Echtzeit-Anwendungen erfordert eine Abkehr von der klassischen IT-Architektur. Statt auf zentrale Datenbanken zu setzen, die periodisch abgefragt werden, etabliert man eine Event-Streaming-Architektur. Das Herzstück vieler solcher Architekturen ist Apache Kafka. Ursprünglich bei LinkedIn entwickelt, um das explosive Datenwachstum zu bewältigen, hat sich Kafka zum De-facto-Standard für die Verarbeitung von Data-in-Motion entwickelt. Kafka agiert als zentrales Nervensystem, das Datenströme von verschiedenen Quellen (z.B. IoT-Sensoren, Web-Klicks, Transaktionssysteme) aufnimmt und sie für verschiedene Konsumenten (z.B. Analyse-Tools, Dashboards, andere Anwendungen) in Echtzeit bereitstellt.

Neben Kafka gibt es weitere wichtige Technologien im Ökosystem:

- Stream-Processing-Frameworks: Werkzeuge wie Apache Flink oder Apache Spark Streaming ermöglichen die eigentliche Verarbeitung und Analyse der Datenströme. Sie können komplexe Operationen wie Filterung, Aggregation oder die Anreicherung von Daten in Echtzeit durchführen.

- In-Memory-Datenbanken: Systeme wie Redis oder Apache Ignite halten Daten im Arbeitsspeicher vor, um extrem niedrige Latenzzeiten bei Abfragen zu gewährleisten, die für Echtzeit-Reaktionen notwendig sind.

- Message Queues: Technologien wie RabbitMQ oder ActiveMQ dienen oft als Puffer und zur Entkopplung von Systemkomponenten, sind aber in der Regel nicht für die Persistenz und den hohen Durchsatz von Big-Data-Strömen ausgelegt, wie es bei Kafka der Fall ist.

Für den deutschen Mittelstand stellt sich oft die Frage nach dem richtigen Implementierungsmodell. Muss man ein eigenes Team von Data-Engineers aufbauen und eine Open-Source-Lösung selbst betreiben? Oder ist eine gemanagte Cloud-Lösung wie Confluent Cloud (Kafka as a Service) oder die entsprechenden Angebote von AWS, Google Cloud oder Azure der bessere Weg? Die Entscheidung hängt von Faktoren wie Kosten, dem Bedarf an Flexibilität und der gewünschten Time-to-Market ab. Gerade für den Einstieg können gemanagte Plattformen den Aufwand erheblich reduzieren.

Zudem gewinnt das Thema Daten-Souveränität in Deutschland und Europa an Bedeutung. Initiativen wie Gaia-X zielen darauf ab, eine sichere und vertrauenswürdige Dateninfrastruktur zu schaffen. Bei der Wahl der Technologie und des Hosting-Modells sollte daher auch evaluiert werden, inwiefern diese Lösungen eine datensouveräne Verarbeitung, z.B. innerhalb deutscher oder europäischer Rechenzentren, gewährleisten können. Die Frage ist nicht nur, ob eine Technologie schnell ist, sondern auch, ob sie den Compliance- und Souveränitätsanforderungen des Unternehmens entspricht.

Schnelle Daten, schnelle Entscheidungen: Wie Sie Ihre Organisation fit für das Echtzeit-Zeitalter machen

Die fortschrittlichste Technologie ist wirkungslos, wenn die Organisation nicht darauf vorbereitet ist, sie zu nutzen. Die Einführung von Echtzeit-Datenverarbeitung ist daher nicht nur ein IT-Projekt, sondern ein tiefgreifender Wandel, der Kultur, Prozesse und Fähigkeiten betrifft. Die Fähigkeit, auf Basis von Live-Daten in Minuten statt in Tagen zu handeln, erfordert eine Organisation, die auf Decision Velocity – also Entscheidungsgeschwindigkeit – ausgerichtet ist.

Ein zentraler Aspekt ist die Demokratisierung der Daten. Wenn Echtzeit-Informationen in den Silos der IT-Abteilung gefangen bleiben, verpufft ihr Potenzial. Fachabteilungen wie Marketing, Logistik oder Produktion müssen über Self-Service-Analyse-Tools und intuitive Dashboards direkten Zugriff auf die für sie relevanten Datenströme erhalten. Dies erfordert nicht nur die richtigen Werkzeuge, sondern auch eine neue Denkweise: weg von der auftragsbasierten Berichterstellung hin zur explorativen Analyse durch die Fachexperten selbst.

Parallel dazu muss in die Fähigkeiten der Mitarbeiter investiert werden. Der Umgang mit Echtzeit-Daten und die Interpretation von sich ständig ändernden Mustern erfordert neue Kompetenzen. Datenschutz ist hierbei ein kritisches, aber oft vernachlässigtes Thema. Es ist alarmierend, dass, wie eine Studie belegt, rund 60 % der Mittelständler keine regelmässigen Datenschutz-Schulungen durchführen. In einer Echtzeit-Welt, in der jeder Klick potenziell eine rechtliche Implikation hat, ist diese Lücke fatal.

Die Transformation hin zu einem echtzeitfähigen Unternehmen ist ein Marathon, kein Sprint. Sie beginnt mit der Identifikation eines konkreten Business-Problems, das durch geringere Latenz gelöst werden kann. Ein erfolgreiches Pilotprojekt schafft nicht nur technischen Mehrwert, sondern dient auch als interner Leuchtturm, der die Vorteile des neuen Ansatzes demonstriert und die Akzeptanz für weitere Schritte im gesamten Unternehmen fördert. Für deutsche KMU existieren zudem diverse Förderprogramme für Digitalisierung, die bei der Finanzierung solcher Transformationsprojekte unterstützen können.

Digital, aber sicher: Die grundlegenden Cybersicherheits-Massnahmen für jedes KMU

Die Vernetzung von Systemen und die Verarbeitung von Datenströmen in Echtzeit schaffen enorme Werte, aber auch neue Angriffsvektoren. Für jedes kleine und mittlere Unternehmen (KMU) in Deutschland ist es daher unerlässlich, Cybersicherheit nicht als Kostenfaktor, sondern als fundamentale Voraussetzung für die digitale Transformation zu begreifen. Die Bedrohungen für Echtzeit-Systeme sind spezifisch: DDoS-Angriffe (Distributed Denial of Service) zielen darauf ab, Streaming-Endpunkte lahmzulegen und so den Datenfluss zu unterbrechen, was ganze Produktionslinien oder Online-Shops zum Stillstand bringen kann.

Eine weitere kritische Schwachstelle sind oft unzureichend gesicherte IoT-Geräte. Jeder Sensor in einer Produktionshalle, jeder vernetzte Scanner in einem Lager ist ein potenzielles Einfallstor in das Unternehmensnetzwerk. Die Absicherung dieser Geräte durch starke Passwörter, regelmässige Firmware-Updates und Netzwerksegmentierung ist keine Option, sondern eine Notwendigkeit. Es gilt das Prinzip des „Zero Trust“: Kein Gerät und kein Nutzer ist standardmässig vertrauenswürdig.

Für Unternehmen, die mit dem öffentlichen Sektor in Deutschland zusammenarbeiten, ist die Orientierung am BSI-Grundschutz von entscheidender Bedeutung. Das Bundesamt für Sicherheit in der Informationstechnik (BSI) stellt mit den IT-Grundschutz-Kompendien einen umfassenden Standard für den Aufbau eines Informationssicherheits-Managementsystems (ISMS) zur Verfügung. Die Umsetzung dieser Empfehlungen ist nicht nur ein Qualitätsmerkmal, sondern oft auch eine formale Anforderung bei öffentlichen Ausschreibungen.

Die grundlegenden Massnahmen umfassen dabei technische Aspekte wie Firewalls und Virenschutz, aber vor allem auch organisatorische Regelungen. Dazu gehören ein klares Berechtigungsmanagement (wer darf auf welche Daten zugreifen?), Notfallpläne für den Fall eines Datenlecks und vor allem die regelmässige Schulung der Mitarbeiter. Der Mensch bleibt oft das schwächste Glied in der Sicherheitskette. Die Sensibilisierung für Phishing-Angriffe und Social Engineering ist eine der effektivsten und kostengünstigsten Sicherheitsmassnahmen überhaupt.

Die Technik hinter der Magie: Wie CRM-Systeme und Co. die persönliche Kundenansprache ermöglichen

Eine personalisierte E-Mail, die genau das Produkt empfiehlt, das man sich gerade angesehen hat, oder ein Rabattcode, der im perfekten Moment auf dem Smartphone erscheint – was für Kunden wie Magie wirkt, ist das Ergebnis hochentwickelter Echtzeit-Datenarchitekturen. Klassische CRM-Systeme (Customer Relationship Management) stossen hier an ihre Grenzen. Sie sind exzellent darin, statische Kundendaten und vergangene Interaktionen zu verwalten (Data-at-Rest), aber sie sind nicht dafür gebaut, das aktuelle Verhalten eines Kunden in Echtzeit zu interpretieren und darauf zu reagieren.

Der evolutionäre Schritt ist der Übergang vom klassischen CRM zu einer Real-Time Customer Data Platform (CDP). Eine CDP bricht die Datensilos zwischen verschiedenen Systemen (Website, App, Kasse, E-Mail-Tool) auf. Sie führt alle Kundeninteraktionen aus allen Kanälen zu einem einheitlichen Kundenprofil zusammen – und das in Echtzeit. Jeder Klick, jede Suche, jeder Warenkorb-Abbruch wird als Event in die Plattform gestreamt und steht sofort für Marketing-Automatisierung und Personalisierung zur Verfügung.

Ein eindrucksvolles Beispiel für die Leistungsfähigkeit solcher Systeme ist der YouTube-Algorithmus. Wie eine Analyse von datenbasiert.de zeigt, handelt es sich dabei nicht um ein einzelnes Programm, sondern um ein Netzwerk verschiedener KI-Modelle. Diese verarbeiten das Verhalten von Milliarden von Nutzern weltweit in Echtzeit, um die Empfehlungen für die Startseite, das nächste Video und die Shorts-Timeline zu personalisieren. Faktoren wie Klickverhalten, Watch Time, Kommentare und sogar die Scroll-Geschwindigkeit fliessen live in die Entscheidungen ein. Dieses System ist ein Paradebeispiel für eine Event-Streaming-Architektur im ganz grossen Massstab, die auf Data-in-Motion basiert.

Für Unternehmen bedeutet dies: Die Fähigkeit zur personalisierten Ansprache im Millisekundenbereich hängt direkt von der zugrundeliegenden Datenarchitektur ab. Solange Kundendaten in verschiedenen, langsam kommunizierenden Silos gefangen sind, bleibt jede Personalisierung reaktiv und verzögert. Erst eine zentrale, ereignisgesteuerte Plattform wie eine CDP ermöglicht eine truly-omnichannel und echtzeitfähige Customer Experience.

Das Wichtigste in Kürze

- Echtzeit-Datenverarbeitung bedeutet einen Wechsel vom reaktiven Analysieren alter Daten (Batch) zum proaktiven Steuern durch Datenströme (Event-Streaming).

- Der wahre Wert liegt in neuen Anwendungen wie Predictive Maintenance oder sofortiger Betrugserkennung, die auf geringer Latenz basieren.

- Die Transformation erfordert neben der Technologie (z.B. Kafka) vor allem eine Anpassung der Organisation, der Prozesse und der Mitarbeiter-Skills.

Vom Datenfriedhof zum strategischen Schatz: Wie Sie Datenanalyse zur Entscheidungsfindung nutzen

In vielen Unternehmen existieren riesige Datenmengen in sogenannten Data Warehouses oder „Data Lakes“. Doch allzu oft werden diese zu einem Datenfriedhof: Die Daten ruhen dort, werden nur sporadisch für rückblickende Berichte genutzt und entfalten nie ihr volles strategisches Potenzial. Der Wert von Daten zerfällt mit der Zeit – eine Information über einen potenziellen Kunden ist in dem Moment am wertvollsten, in dem er mit Ihrer Marke interagiert, nicht eine Woche später. Die Transformation vom Datenfriedhof zum strategischen Schatz gelingt nur durch die Verbindung von historischen Daten mit Live-Datenströmen.

Eine fortschrittliche Architektur, um dies zu erreichen, ist die sogenannte Lambda-Architektur. Sie kombiniert den traditionellen Batch-Layer, der für die Analyse grosser historischer Datenmengen zuständig ist, mit einem Speed-Layer (Echtzeit-Schicht), der Live-Datenströme verarbeitet. Das Ergebnis ist eine hybride Sicht, die es ermöglicht, Prognosen auf Basis langfristiger Trends (aus den historischen Daten) mit aktuellen Ereignissen (aus dem Live-Stream) in Echtzeit zu kombinieren. So kann ein E-Commerce-Unternehmen beispielsweise seine generellen Verkaufsprognosen für ein Produkt live anpassen, wenn ein Influencer es gerade in den sozialen Medien erwähnt und einen Nachfrage-Peak auslöst.

Um den Erfolg dieser Transformation messbar zu machen, müssen neue KPIs etabliert werden. Statt nur auf Umsatz oder Kosten zu blicken, werden Kennzahlen wie „Time to Insight“ (die Zeit von der Datenerfassung bis zur gewonnenen Erkenntnis) und „Decision Velocity“ (die Geschwindigkeit, mit der das Unternehmen auf Basis dieser Erkenntnis handeln kann) entscheidend. Das Ziel ist es, diesen Zyklus von Tagen auf Minuten oder Sekunden zu verkürzen.

Letztendlich geht es darum, eine datengestützte Kultur zu etablieren, in der Entscheidungen auf allen Ebenen nicht mehr nur auf Intuition, sondern auf harten, aktuellen Fakten basieren. Die Bereitstellung von Self-Service-Analyse-Tools für Führungskräfte ist hier ein entscheidender Schritt. Wenn ein Manager eine Hypothese hat, sollte er in der Lage sein, diese sofort an den Live-Daten zu überprüfen, anstatt auf einen Report der IT-Abteilung warten zu müssen.

Die Implementierung einer Echtzeit-Datenstrategie ist eine strategische Entscheidung, die Ihr Unternehmen transformieren kann. Der erste Schritt besteht darin, das Potenzial für Ihr spezifisches Geschäftsmodell zu bewerten und ein erstes Pilotprojekt zu definieren, um den Mehrwert schnell und greifbar nachzuweisen.

Häufige Fragen zur Echtzeit-Datenverarbeitung

Welche spezifischen Cyber-Risiken bergen Echtzeit-Systeme?

DDoS-Angriffe auf Streaming-Endpunkte und ungesicherte IoT-Geräte in der Produktionshalle sind die Hauptrisiken, da sie als ungeschützte Datenquellen dienen können. Eine Unterbrechung des Datenstroms kann kritische Geschäftsprozesse sofort lahmlegen.

Was ist der BSI-Grundschutz und warum ist er wichtig?

Der BSI-Grundschutz ist ein Standard des Bundesamts für Sicherheit in der Informationstechnik (BSI), der Methoden, Prozesse und Massnahmen zur Informationssicherheit beschreibt. Für Unternehmen in Deutschland kann die Konformität entscheidend sein, insbesondere bei Aufträgen aus dem öffentlichen Sektor.

Wie schnell muss bei Datenlecks in Echtzeit-Systemen reagiert werden?

Die Reaktionsgeschwindigkeit ist bei Echtzeit-Systemen noch kritischer als bei anderen Systemen. Gemäss DSGVO bestehen strenge Meldepflichten an die zuständigen deutschen Landesdatenschutzbehörden. Ein Data Breach muss in der Regel innerhalb von 72 Stunden nach Bekanntwerden gemeldet werden.